Lorsque l’on songe aux enjeux parmi les plus importants liés à la protection des droits humains dans notre pays aujourd’hui, mais aussi demain, l’un des sujets qui s’impose très vite est celui de la prégnance de multiples outils et processus technologiques dans nos vies.

Lorsque l’on songe aux enjeux parmi les plus importants liés à la protection des droits humains dans notre pays aujourd’hui, mais aussi demain, l’un des sujets qui s’impose très vite est celui de la prégnance de multiples outils et processus technologiques dans nos vies.

Bien sûr, il y a toujours des personnes qui dorment dans la rue, il y a toujours des sans-papiers violemment expulsés, il y a toujours des personnes détenues dans des conditions indignes, il y a toujours des interventions policières condamnables, il y a toujours des individus discriminés pour de multiples raison, il y a toujours des mouvements de grève pénalisés, il y a toujours un mépris du vivant et de son biotope, et on en passe. Si les questions que soulèvent ces plaies de notre société reçoivent insuffisamment d’attention, il semble en être autrement des défis lancés par les « nouvelles » technologies.

A titre d’exemple, l’émergence vertigineuse de l’intelligence artificielle (IA) et des potentialités qu’elle charrie a suscité de nombreux commentaires quant à son impact, à plus ou moins court ou long terme : les conversations sociales, les articles de presse, les discussions politiques… font état des conséquences jugées tantôt positives tantôt négatives, tantôt les deux, qu’elle comporte.

Il nous a semblé, toutefois, que certains éléments de la discussion en la matière sont largement occultés. En effet, cette technologie, qui n’est pas neutre, comme toute technologie d’ailleurs, vient s’inscrire dans un cadre social et politique existant, avec une série d’effets qu’il est important de ne pas négliger.

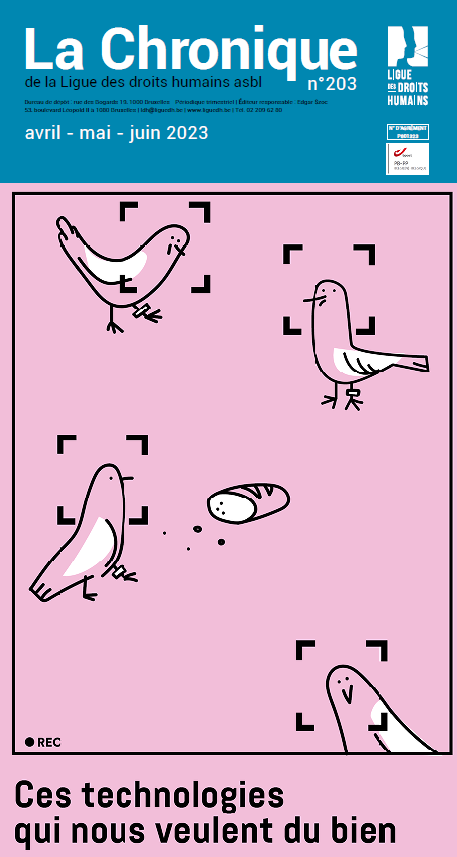

Ainsi, le déploiement de ces outils vient ajouter une couche technologique à un tissu de mécanismes et de processus existants. Dès lors, les procédés de surveillance, déjà omniprésents dans nos villes, se voient dotés de potentialités qui alourdissent des craintes déjà exprimées, comme l’illustre le recours massif à la vidéosurveillance de l’espace public, au moyen de caméras dotées de dispositifs « intelligents » à l’efficacité toute relative (C. Dubailleul) et/ou aux possibilités inquiétantes (G. Hugo ).

De même, le recours aux algorithmes s’insère dans des pans de plus en plus larges de la société, accentuant des inégalités existantes ou en en créant de nouvelles, comme l’illustre le contrôle algorithmique de la fraude sociale (E. Degrave, C. Martens et L. Roy) ou encore le développement de « smart cities » qui laissent sur le bord de la route de nombreux·ses habitant.es de nos villes, particulièrement vulnérables. Au niveau judiciaire, également, l’outil technique promet des jours radieux aux magistrat.es, avocat.es et entreprises, leur permettant de « prédire » l’issue d’une procédure, mais en présentant le risque de renforcer une inégalité des armes déjà à l’œuvre entre différent·es acteurs et actrices judiciaires (R. Farge et E. Hardy).

Notons cependant que, si ces mutations semblent à d’aucun·es inéluctables, nous estimons qu’il n’en est rien. Par exemple, la LDH et ses partenaires ont récemment obtenu du Parlement bruxellois une audition sur la question du recours à la reconnaissance faciale dans l’espace public afin de susciter un débat politique totalement absent en la matière (A. Wavreille). C’est peu face à l’ampleur des enjeux. Mais c’est un premier pas pour atteindre un objectif fondamental : ne pas nous laisser submerger par des évolutions qui n’en ont parfois que le nom et reprendre en main notre capacité de réflexion et d’action.

Edito

Manuel Lambert

1- Reconnaissance faciale : souriez, vous êtes filmé·es… et identifié·es

Aline Wavreille

2 – Justice : prédire la place de l’IA

Rémy Farge et Emmanuelle Hardy

3 – Vidéosurveillance à Bruxelles : installer des caméras, mais pourquoi ?

Corentin Debailleul

4 – Les droits fondamentaux face aux algorithmes du secteur public

Elise Degrave, Clément Maertens et Laurent Roy

5 – VSA jacta est

Garance Hugo

Illustrations : Mathilde Collobert